Topics

ここでは伊藤・能勢研で扱っている研究テーマの一部を紹介します。

・高精度な大語彙連続音声認識システム

・人間のように感情豊かに話す音声合成

・豊かなコミュニケーションに向けた画像合成

・声真似が可能なボイスチェンジャー

・音声およびマルチモーダル対話システム

・音声言語処理を応用した外国語教育システム

・高度な音楽情報処理

・高度な音楽配信技術

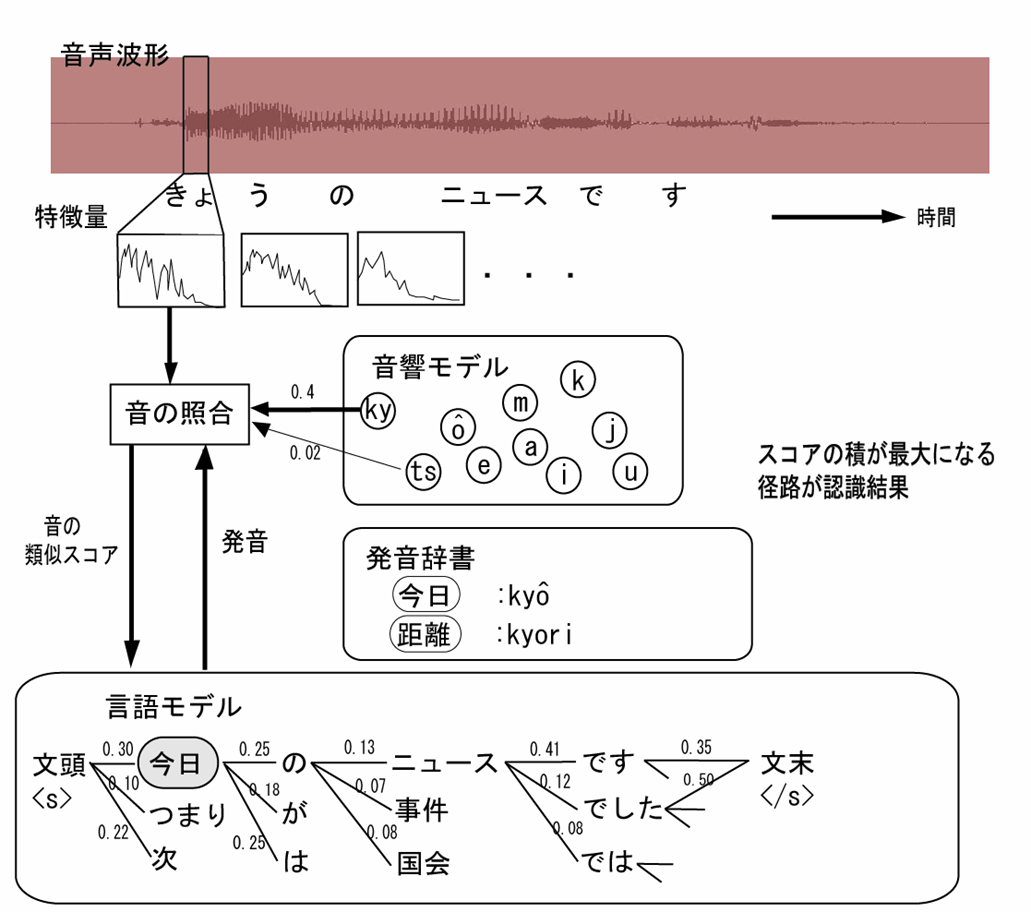

高精度な大語彙連続音声認識システム

■音声認識技術

音声認識技術とは、簡単に言うと人間の喋った言葉を文字列にする技術です。

この音声認識技術は、映画やニュースに自動で字幕を付与するなどの自動で付与といった

ディクテーションシステム、

音声ファイルを容易に検索できる

音声ドキュメント検索システム、人間とロボットの対話を実現する

音声対話システム、

よりグローバルな世界を体現するためには欠かせない

音声自動翻訳システムなどの実現のためには欠かせない基礎技術です。

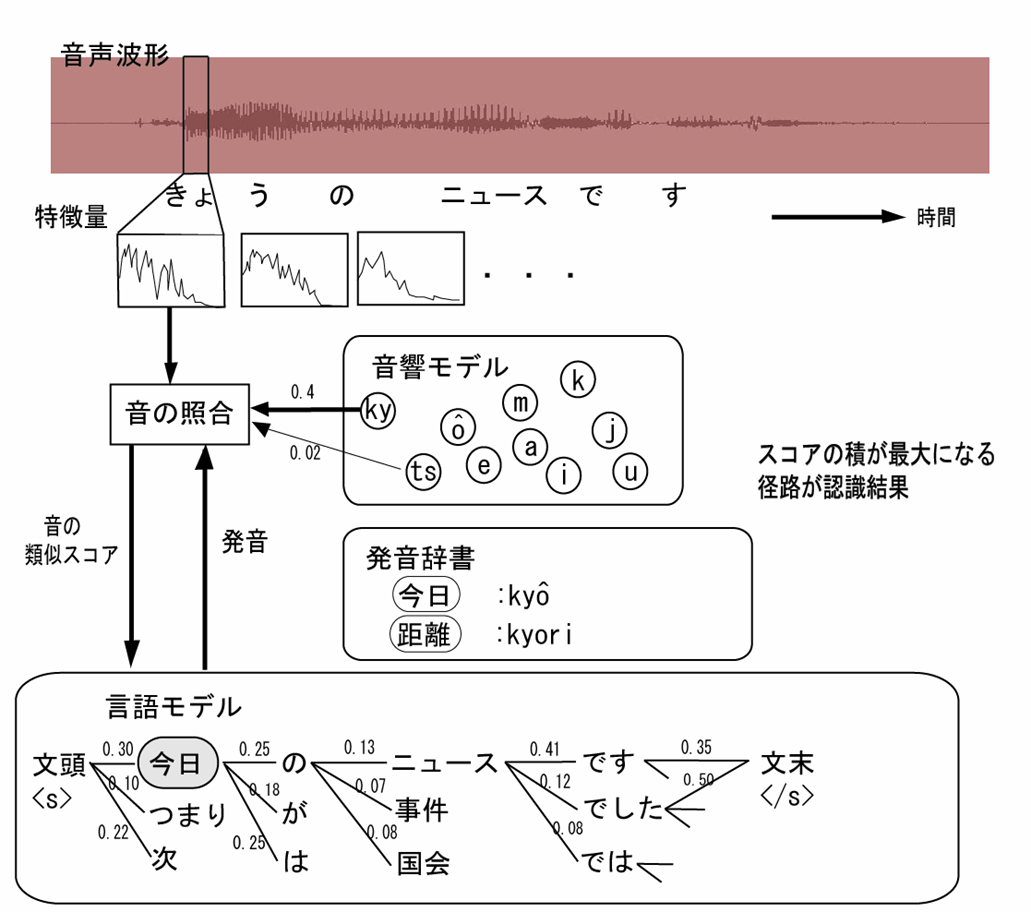

この音声認識技術には、音響的制約と言語的制約から成り立っています。

我々の研究室では、音響的制約を担う

音響モデル、および言語的制約を担う

言語モデルなど、

音声認識技術のさらなる高精度化を目指して様々な研究を行っています。

■音響モデルの高速話者適応技術

■音響モデルの高速話者適応技術

今日の音響的制約は、様々な人の声から統計的に学習しています。

しかし、ロボットが高精度に声を聞き分けるには、話者がとういう声質の持ち主なのかを意識する必要があります。

そこで我々は、少量の話者のデータから高速に話者の声質を捉え、それに適応する研究を行っています。

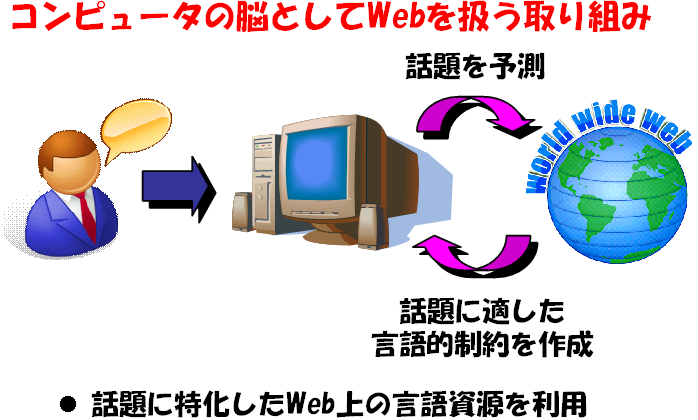

■Web上の言語資源を利用した言語モデル

言語的制約は、人手でルールを作るのではなく、機械が自動でルールを学習するという機械学習に基づいて行われます。

このルールは、大量の文書(新聞など)から学習できます。

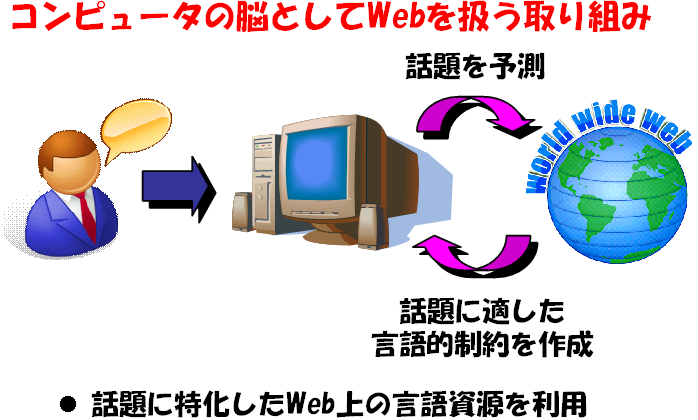

高精度な認識性能を実現するためには、話題に特化してルールを作ることが有効であることが知られています。

そこで我々は、あらゆる話題に含む文書を含む

World Wide Webから、話題に適した学習を行う方法について研究しています。

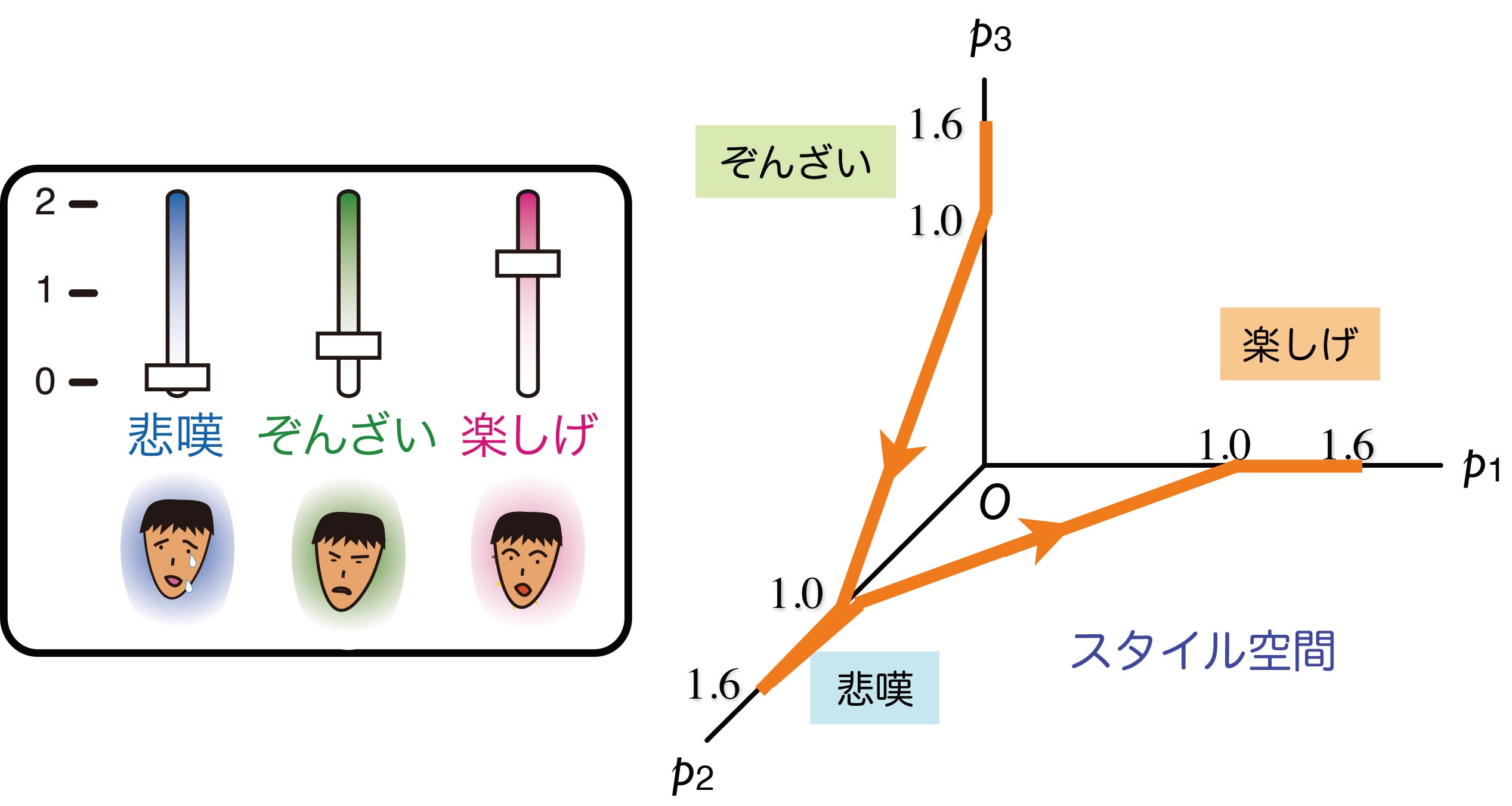

人間のように感情豊かに話す音声合成

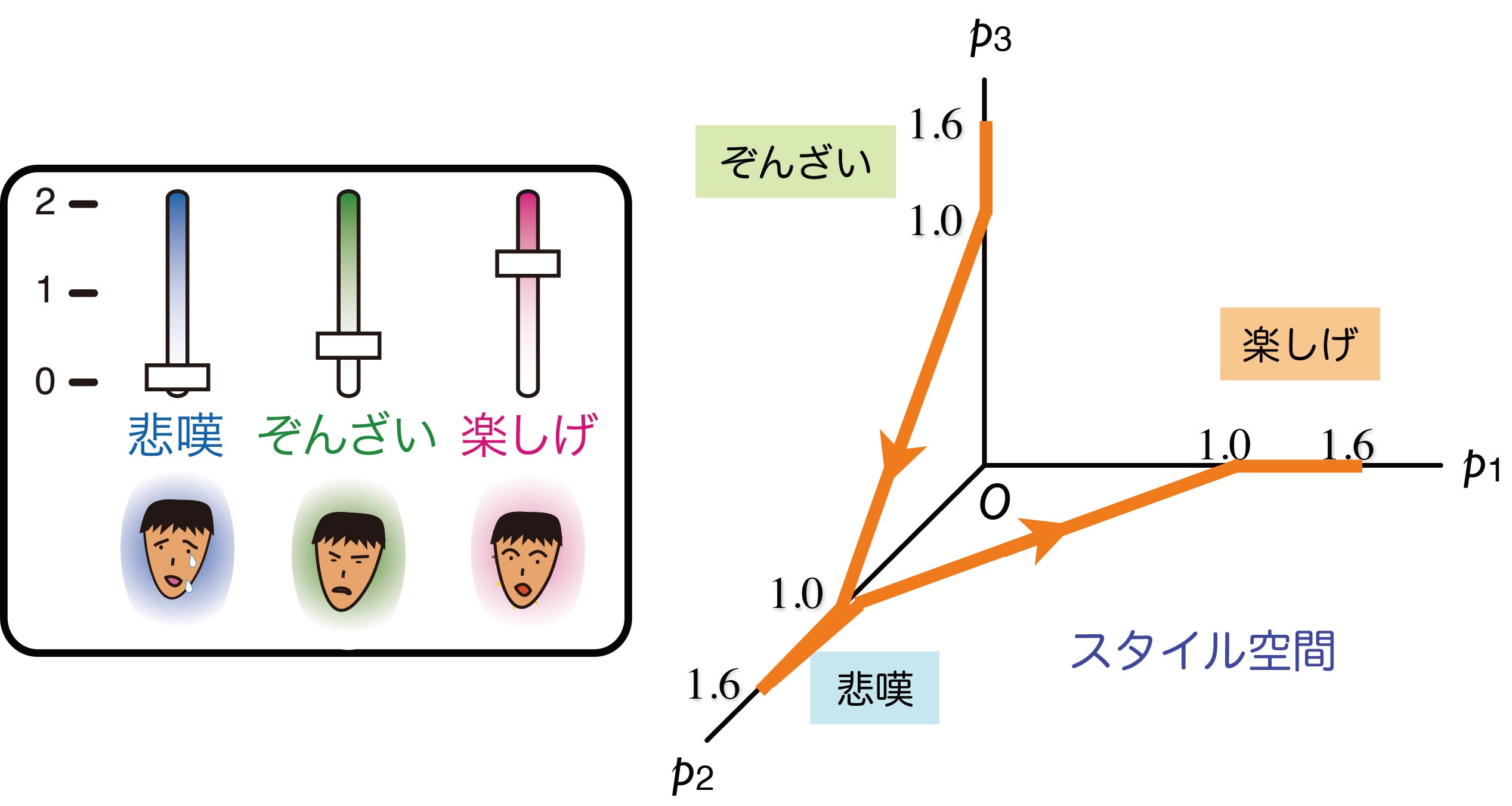

■多様なスタイルによる音声合成

テキストから音声を生成する技術を音声合成と言います。

音声合成はカーナビや公共情報案内、音声対話システム、歌声合成など様々な場面で利用されています。

我々は従来の抑揚のないナレーションのような声ではなく、よりいきいきと多様に感情を変化させることが

できる音声合成手法として

重回帰隠れマルコフモデルに基づくスタイル制御法を提案しています。

このような音声合成は次世代のヒューマノイドロボットの実現のために必須であると考えられます。

■Live2Dでの音声合成の利用

■Live2Dでの音声合成の利用

最近のスマホゲームなどでも多用されている2Dモーフィングアニメーションツール「Live2D」に深層学習に基づく音声合成を導入した例です。研究室のオリジナルキャラクター「川内萌」ちゃんが研究内容について簡単に説明してくれるノベルゲームを作成してみました。より人間らしい話し言葉による音声合成のサンプルを聞くことができます。

こちらからChrome(PC, スマホ)でプレイできます。

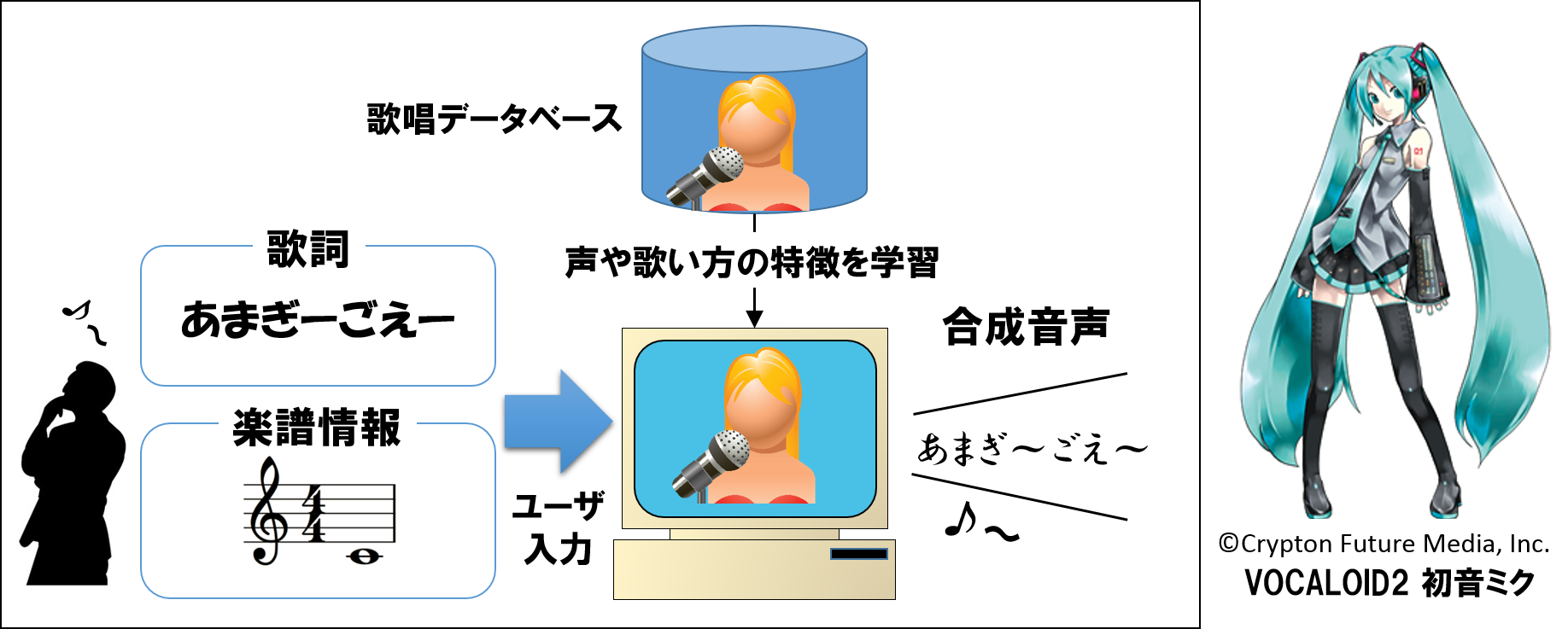

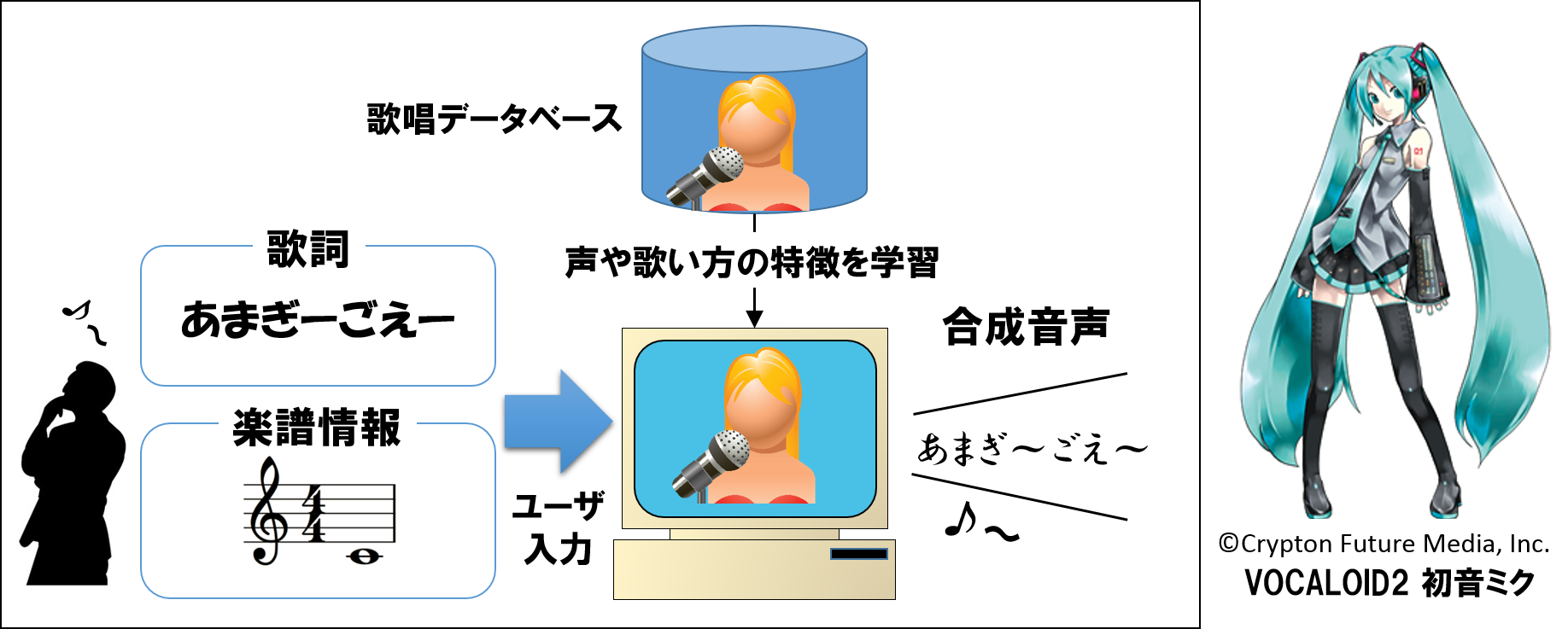

■歌声合成技術

■歌声合成技術

歌声合成技術は、VOCALOID等で知っている方も多いのではないでしょうか。

歌唱が苦手なユーザでも任意の歌唱音声を合成できて、誰でも気軽に楽曲を作ることができます。

しかし、まだ人間の歌声とは大きな差があるのが現状です。我々は既存の歌声合成に替わる高品質で様々な歌唱法を再現・制御可能な統計モデルに基づく歌声合成法について研究を行っています。

合成された歌声(Youtubeにジャンプします)

合成された歌声(Youtubeにジャンプします)

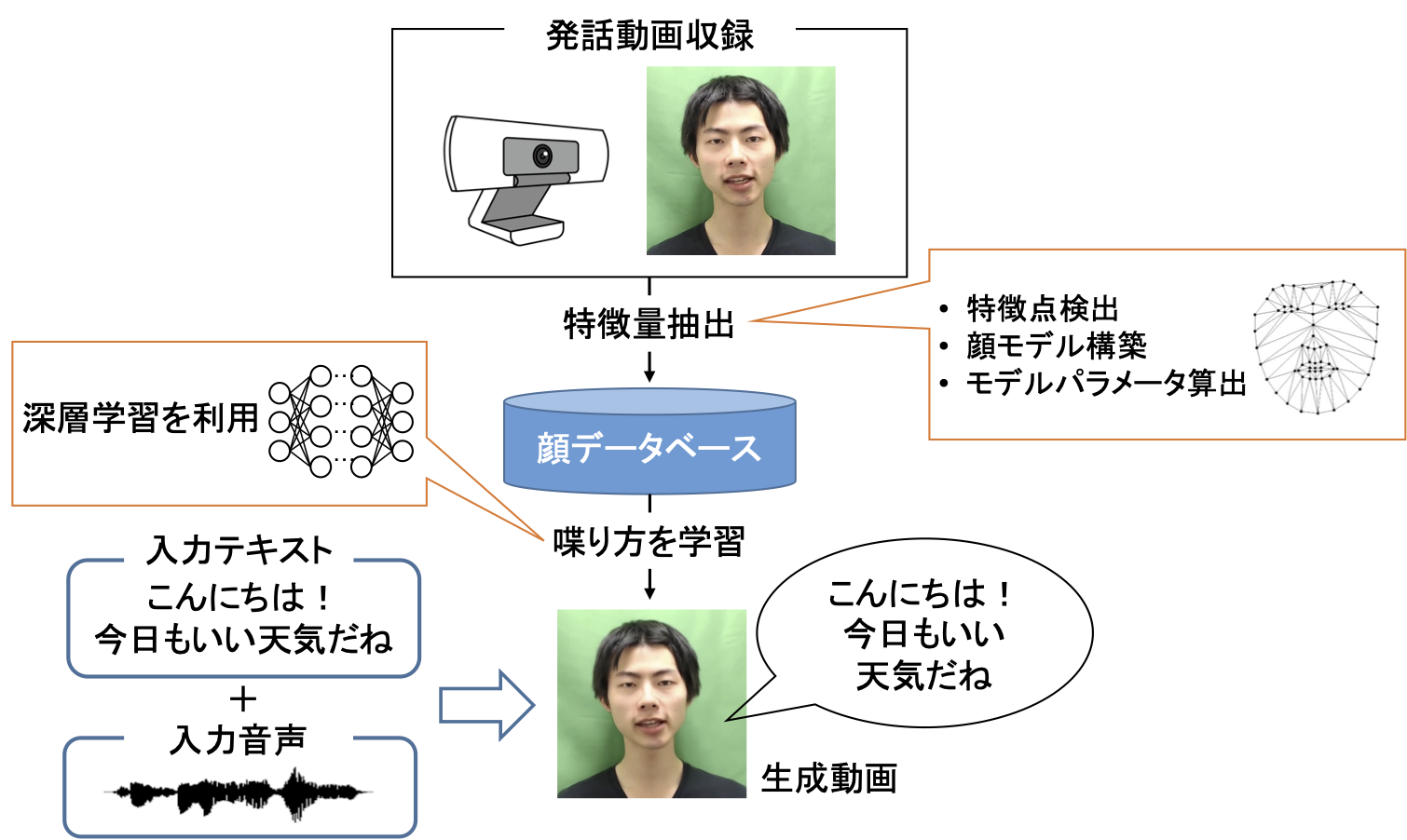

豊かなコミュニケーションに向けた画像合成

■画像特徴量を用いたテキストからの顔動画像生成

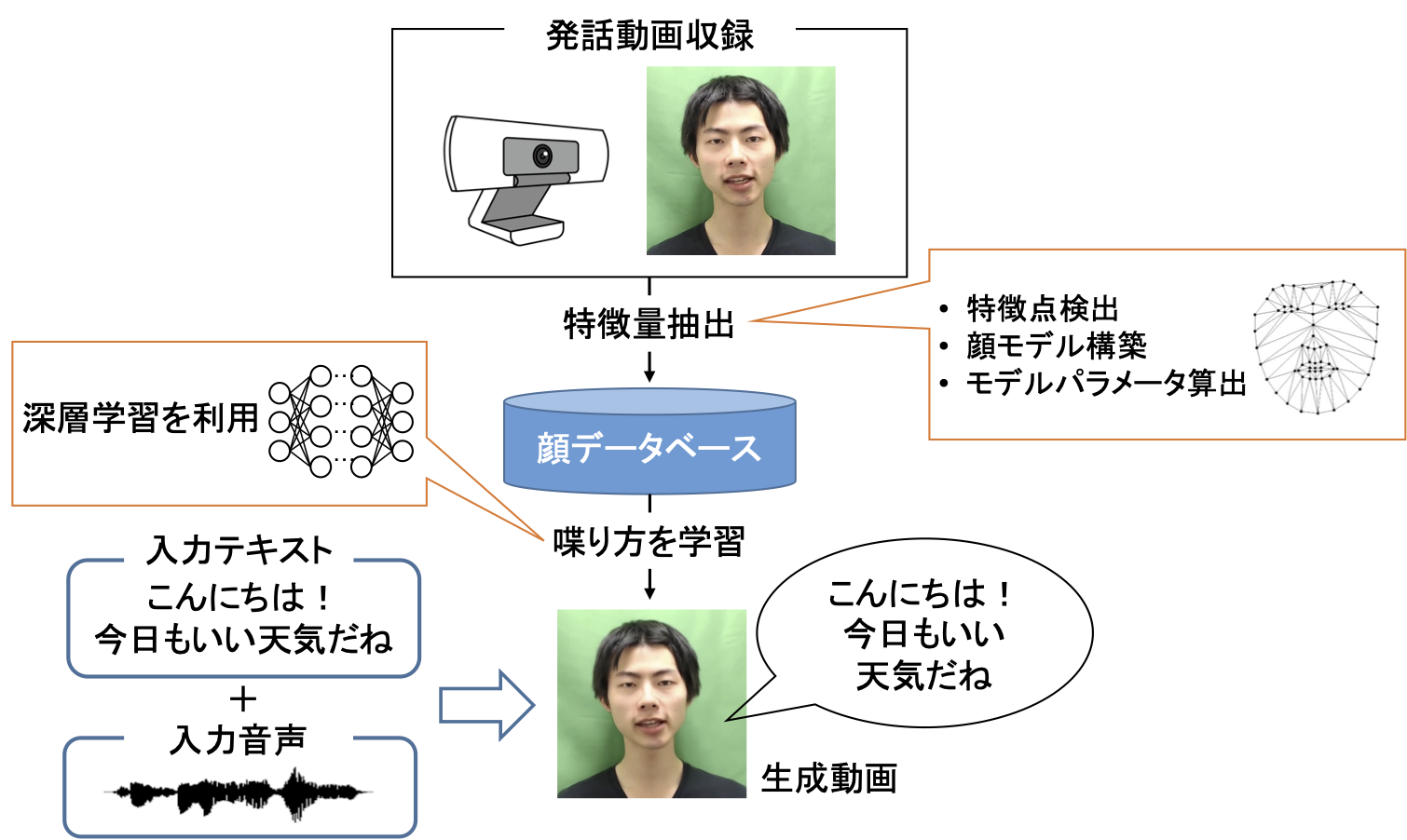

現在実用化されている音声対話システムは”人間らしい"と感じられるでしょうか?"人間らしさ"を構成する要素は様々考えられますが、我々はその中でも対話エージェントの"見た目"に着目しました。人と人とのコミュニケーションにおいて、視覚情報、特に人の顔の情報は重要な役割を果たします。従って、対話エージェントが人と同じように顔を持つことで対話システムの人らしさが向上し、人と対話システムとのコミュニケーションがより豊かなものになると考えられます。

そこで我々は、”リアル"な対話エージェントの実現を目指し、深層学習を用いて発話内容に応じた顔の動きを予測し描画することで、リアルな人の発話動画像を生成する技術について研究を行っています。この技術と音声合成技術とを組み合わせることで、任意の発話内容を喋る目標話者の映像を生成することが可能となり、対話システムだけでなく様々な映像コンテンツ制作への応用も期待されます。

| オリジナル |

テキストより生成 |

目を閉じたまま |

ずっとまばたき |

|

|

|

|

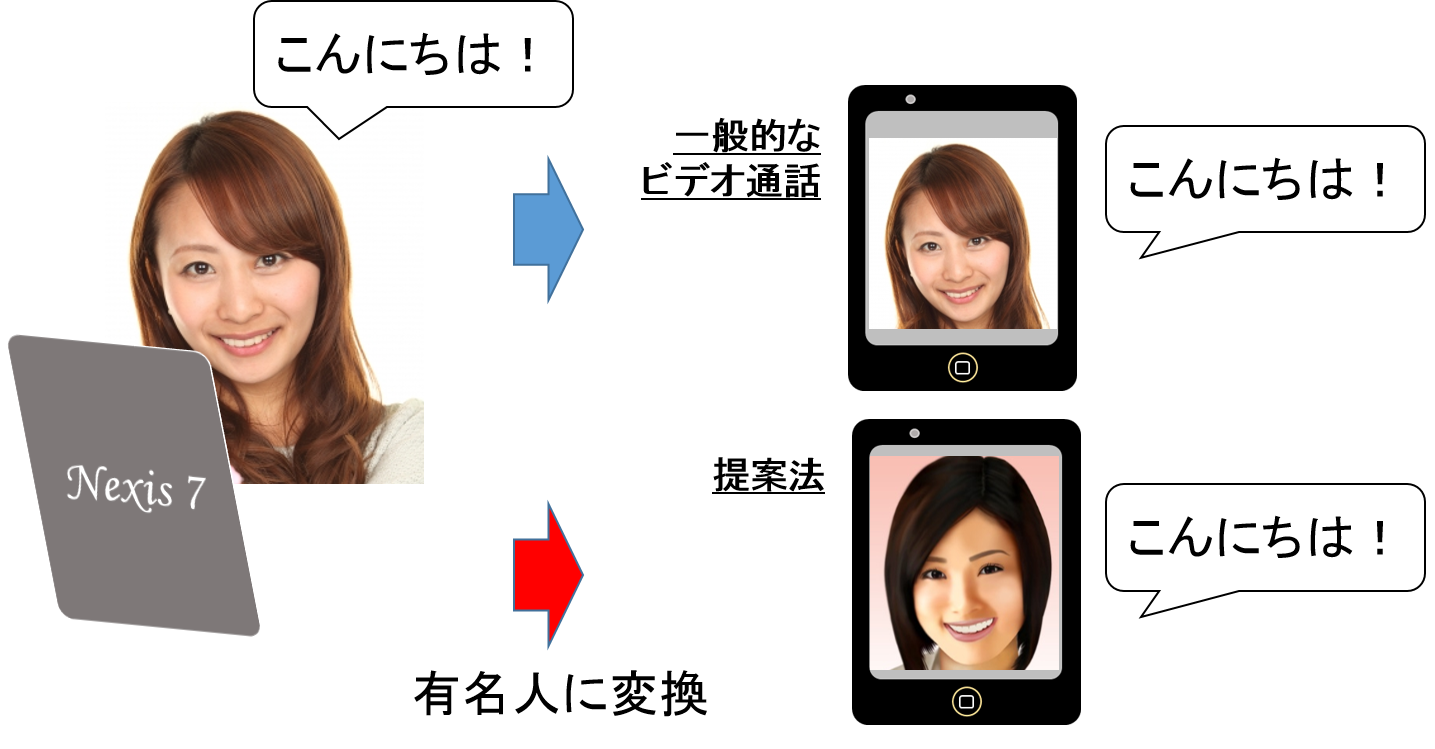

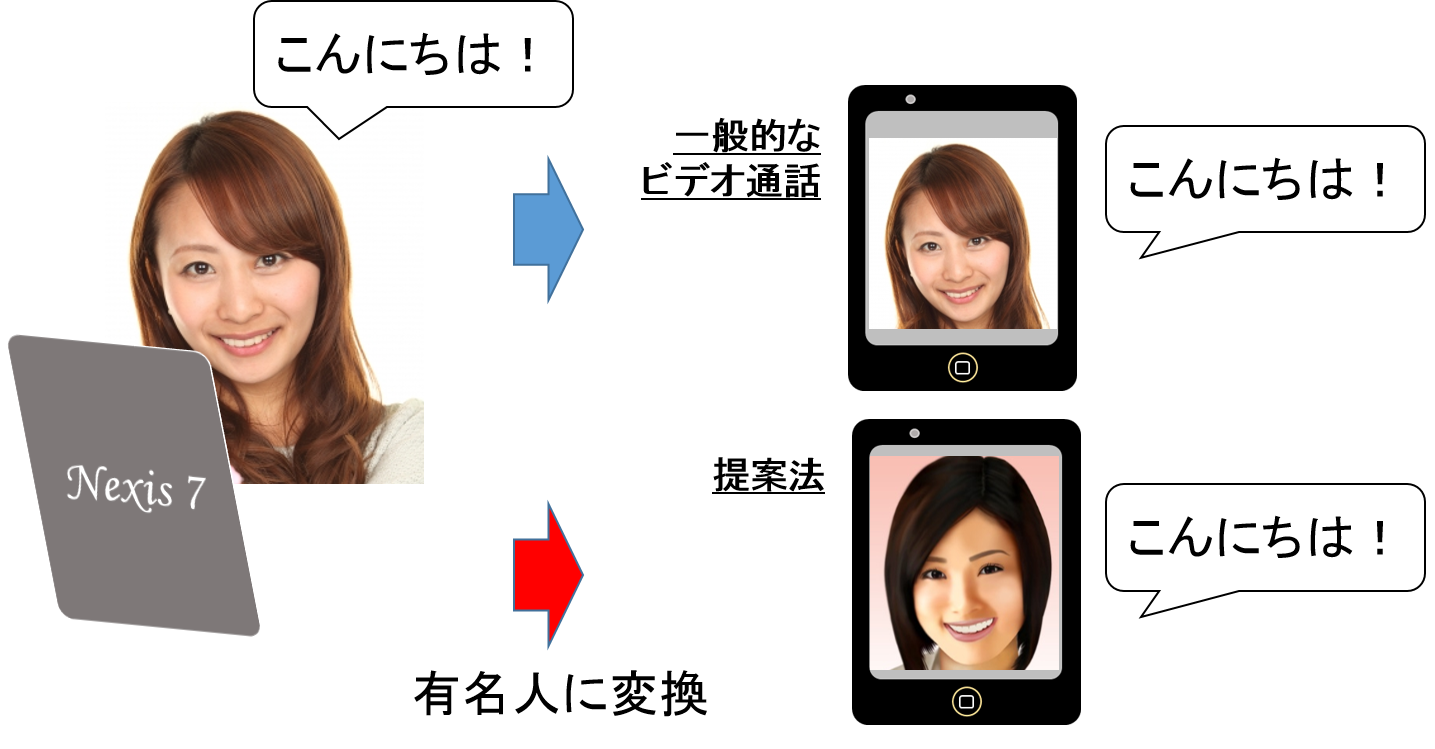

■Kinectを用いた顔画像変換技術

近年、SkypeやFaceTime、LINEといったアプリケーションにおけるビデオ通話が日常生活に浸透してきています。ビデオ通話を使うことによって、相手の表情や身振りなどを見ることができるので、声だけでは伝わらない情報も知ることができます。 その一方で、「顔」が相手が伝わるために敷居が高く、親しい人以外はあまり使わないという方が多いのではないでしょうか?

そこで本研究では、Kinectにより得られる顔特徴量を利用し、表情を維持したまま顔の個人性を別の人(例えば有名人)に変換して、その顔画像を相手に伝えるということを検討しています。声質変換と組み合わせることで有名人になりきってビデオ通話ができるようになります。 有名人になりきれるというエンターテイメント性の高さと個人性を変換することによるプライバシー保護の両面を満たす技術の開発を行っています。

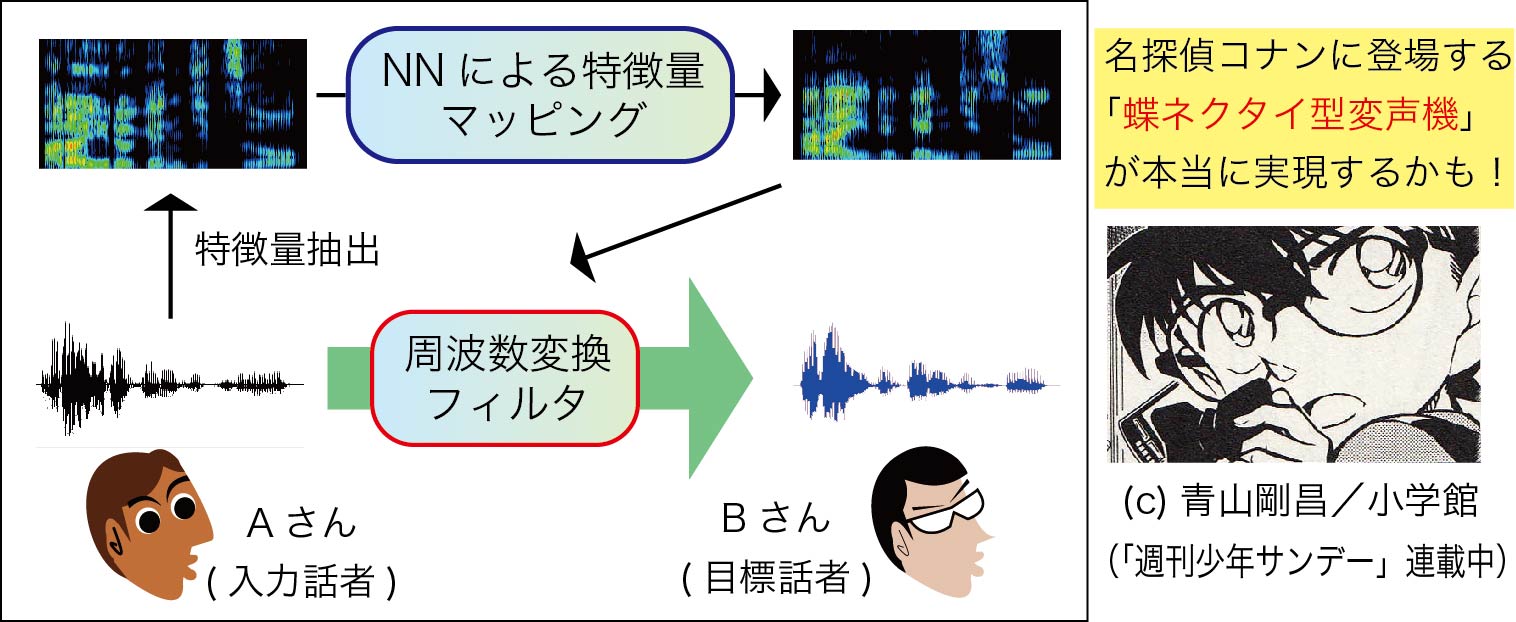

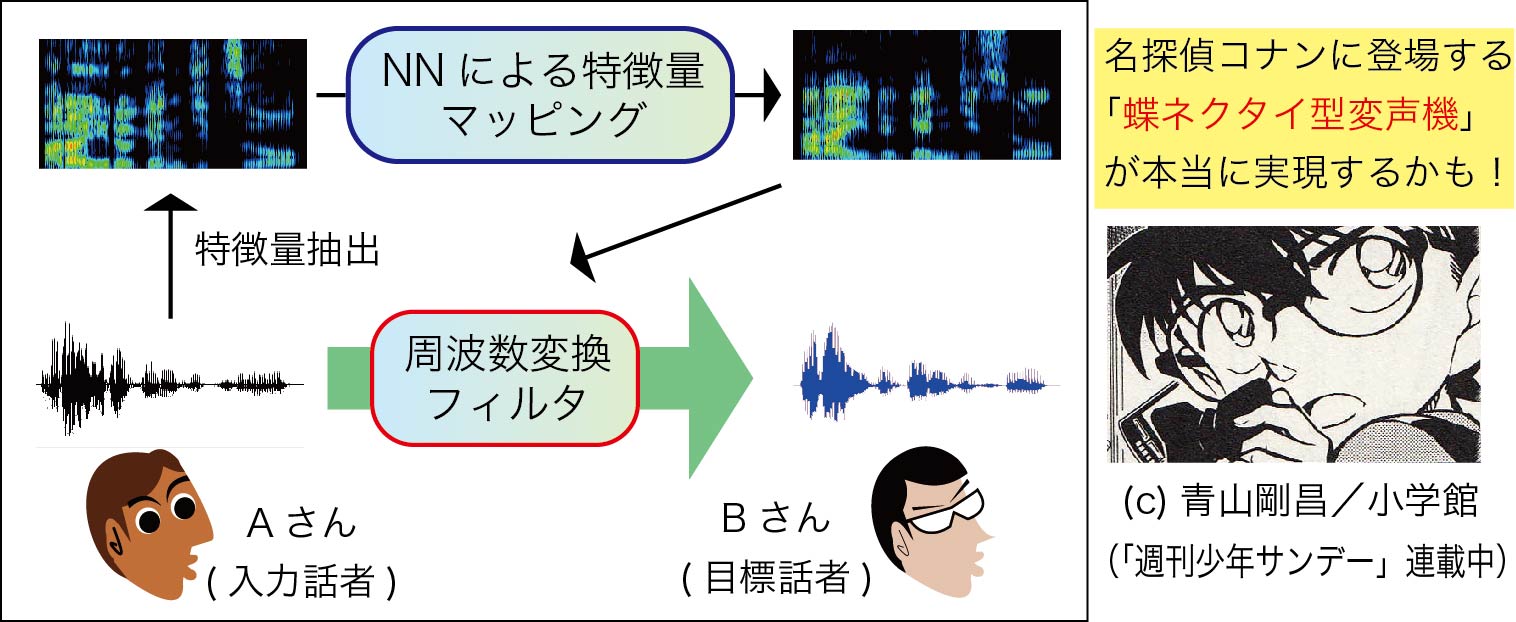

声真似が可能なボイスチェンジャー

■ニューラルネットワークに基づく任意話者声質変換

漫画や映画である人の声を他の人の声に変えてしまう技術を見たことがある方は多いと思います。これは「声質変換」と呼ばれる研究で、理論的には入力話者の周波数特性を変えることによって実現することができます。我々はボイスチャットやカラオケなどでの実用化を目指し、ニューラルネットワーク(NN)を用いることで、誰の声でも目標話者の声にリアルタイムで変換できる技術について研究を行っています。

音声およびマルチモーダル対話システム

■音声対話システム

スマートフォンのアプリケーションや感情を認識するロボットなど、近年では音声で会話ができる音声対話システムが注目を集めています。この研究分野では単純に機械への入力操作を人間の声で代替するだけではなく、SF映画のように人間の話すことを理解し適切な会話ができるシステムの実現を究極の目標としています。

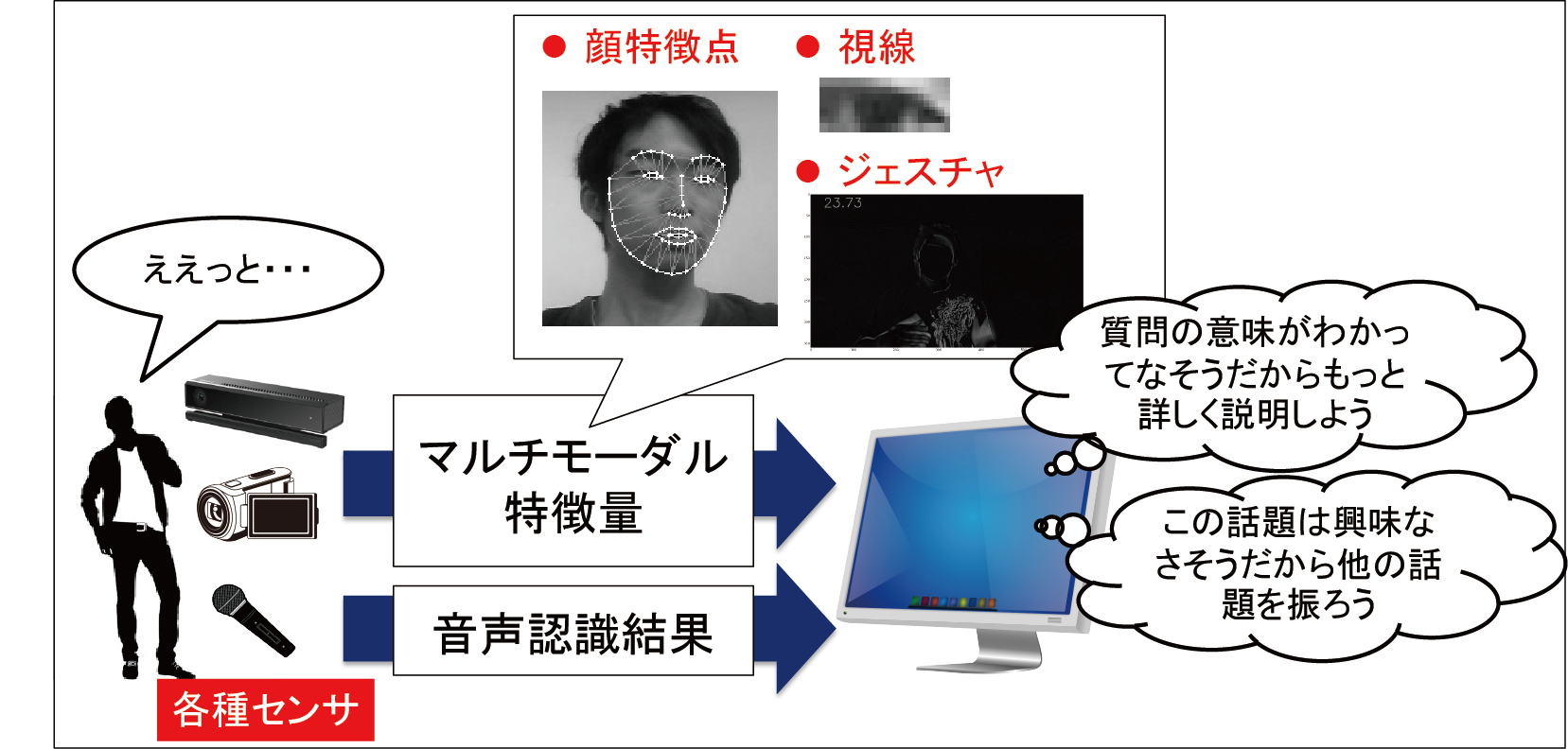

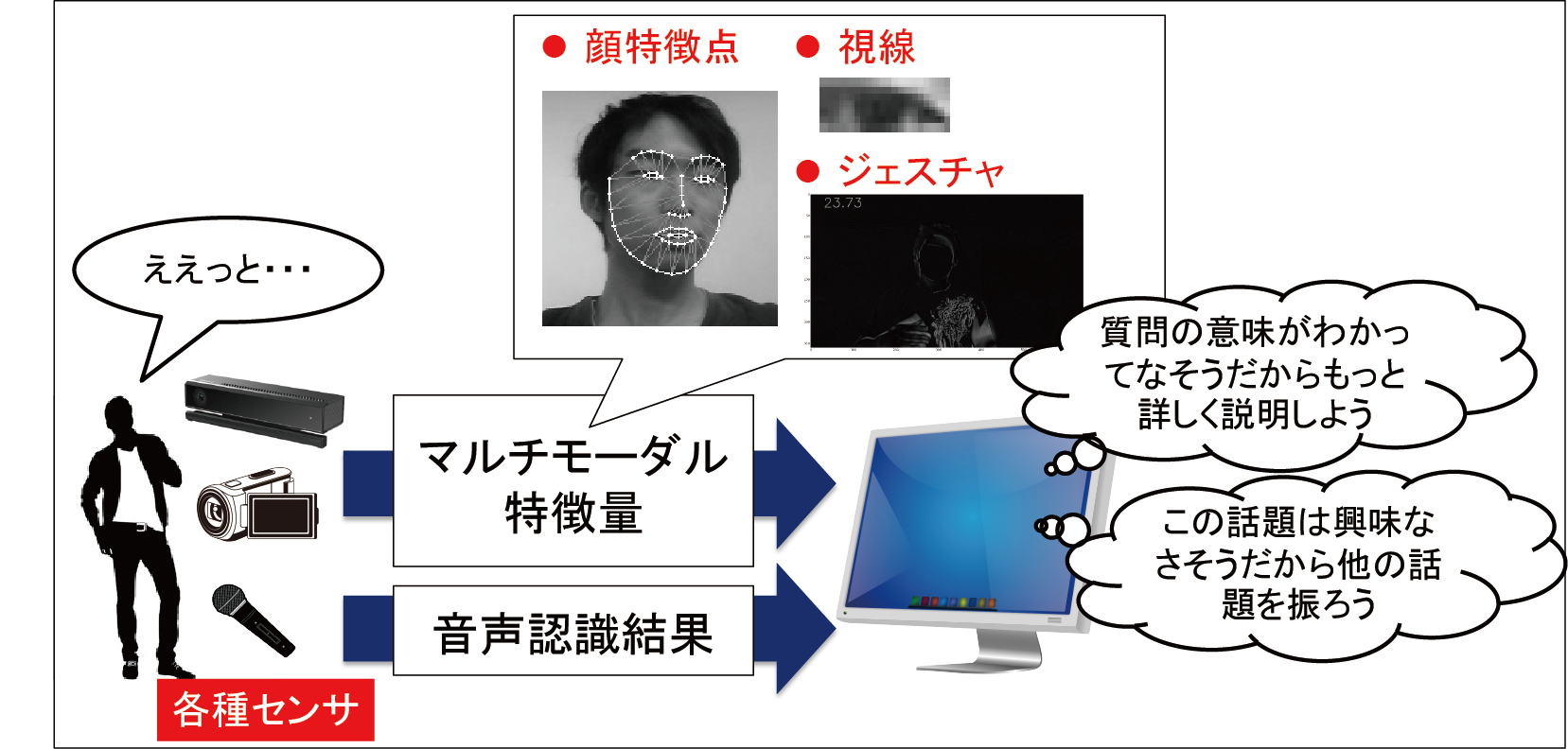

■マルチモーダル対話システム

人間は音声に含まれる言語的な情報だけでなく、抑揚や声の大きさ、表情の変化など様々なモダリティを媒介して多様なコミュニケーションを行っています。しかしながら、一般的な音声対話システムは音声認識結果(言語情報)に大きく依存した対話制御を行っており、非言語的な情報を有効に活用できていないのが現状です。

本研究室では、ビデオカメラやKinectなどのセンサにより得られた表情、視線、ジェスチャ情報を利用し、質問を理解しているかどうか、会話をしたいと感じているかどうかといったユーザの状態を推定することで、より高度で人間らしい対話制御が行える対話システムの実現を目指した研究を行っています。

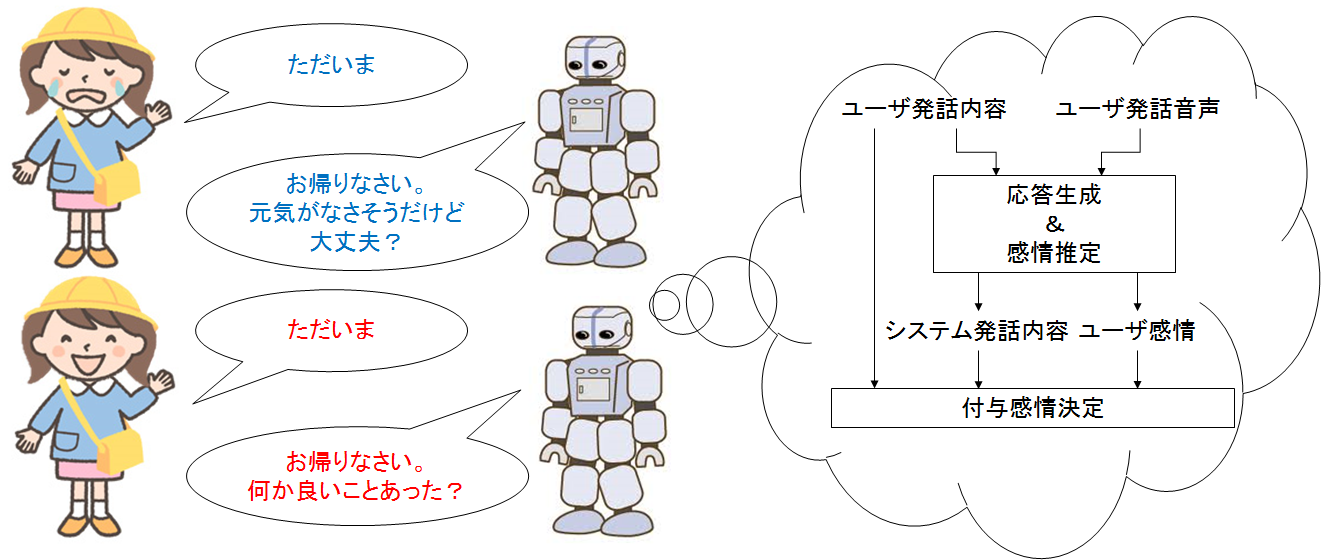

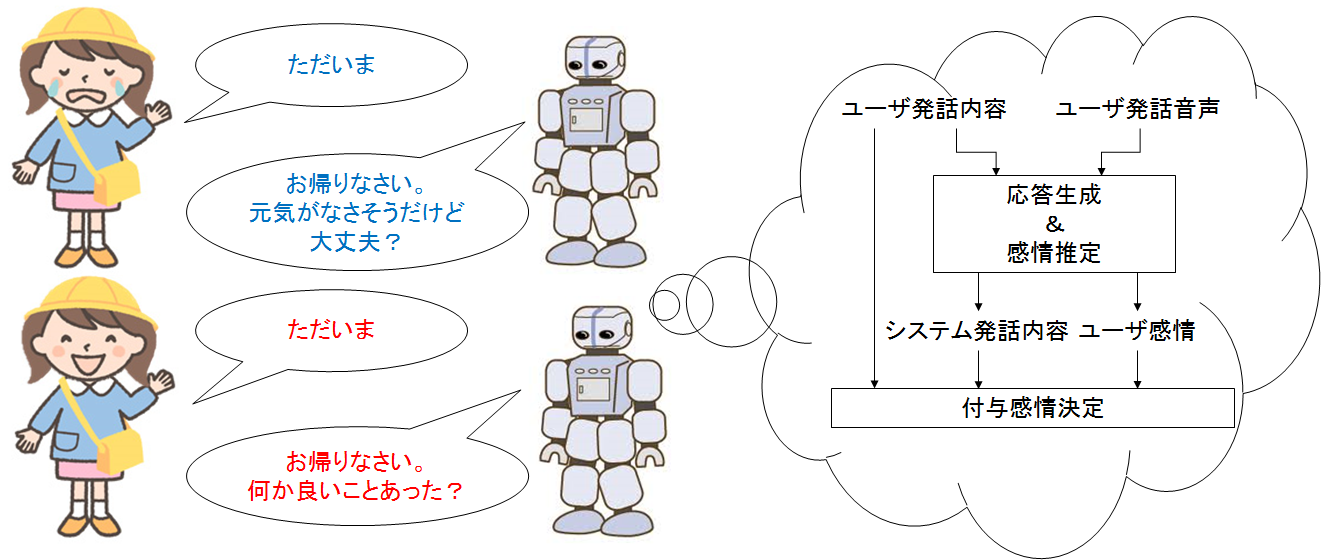

■ユーザの感情を理解し、ユーザに協調的な応答を行う対話システム

■ユーザの感情を理解し、ユーザに協調的な応答を行う対話システム

また、適切な応答を生成するだけでなく、ユーザの発話内容や発話音声からユーザの感情を推定し、ユーザに協調的な応答を行う研究も行われています。さらに、応答の内容だけでなく応答の仕方(例えば感情)を工夫することで、より充実した対話を行うことのできるシステムを目指しています。

この研究ではシステムの発話音声に感情を付与する場合、ユーザ発話内容から推定された感情に協調した感情を付与することがユーザの持つ印象を向上させることが明らかとなりました。今後は発話内容だけでなく発話音声も考慮した方法を検討します。人と機械のコミュニケーションが多くなる将来に向けて、人に優しい対話システムを目指して様々なアプローチから研究を行っていきます。

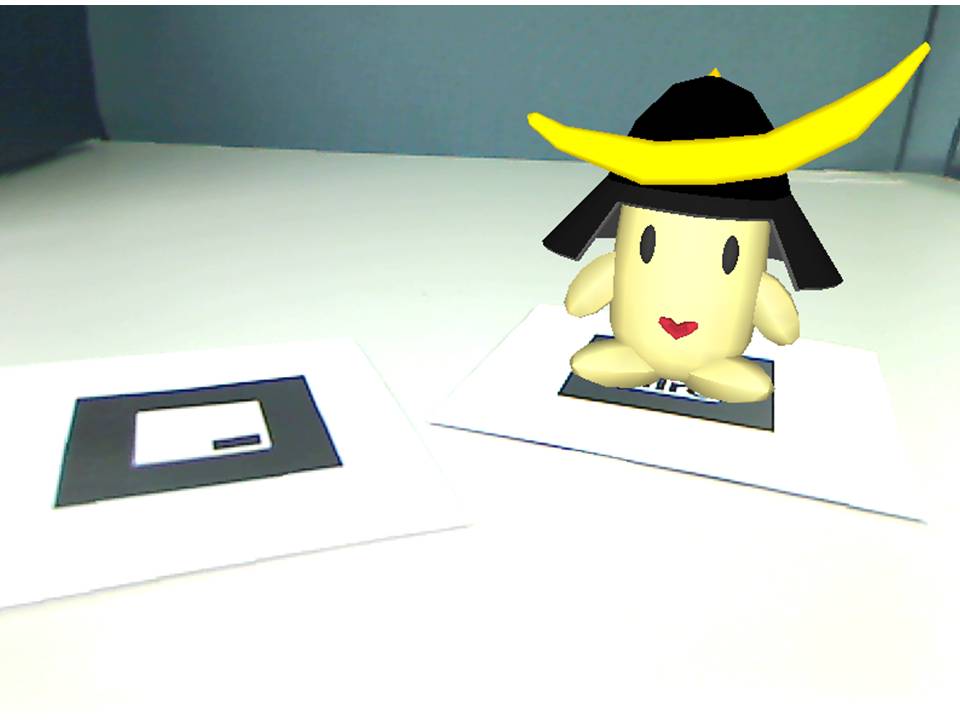

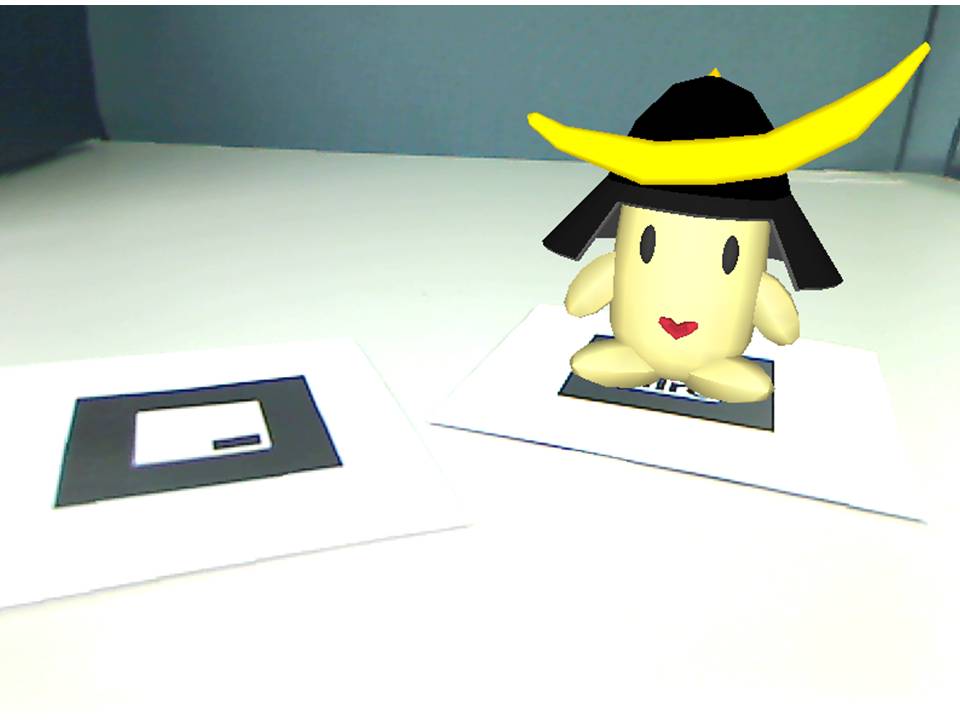

■3DCGによる音声対話エージェント

■3DCGによる音声対話エージェント

対話システムが人間とインタラクションをとるのにふさわしい存在になれるかどうかには、システムの外観も重要な要素になります。本研究室では3DCGによる対話エージェントを作成し、AR技術によって描画されたエージェントとの対話の分析を行いました。この研究では、エージェントと対話を行うことで、対話システムへの親しみやすさや話しかけやすさが向上し、対話システムの応答正答率が向上することを確認しました。

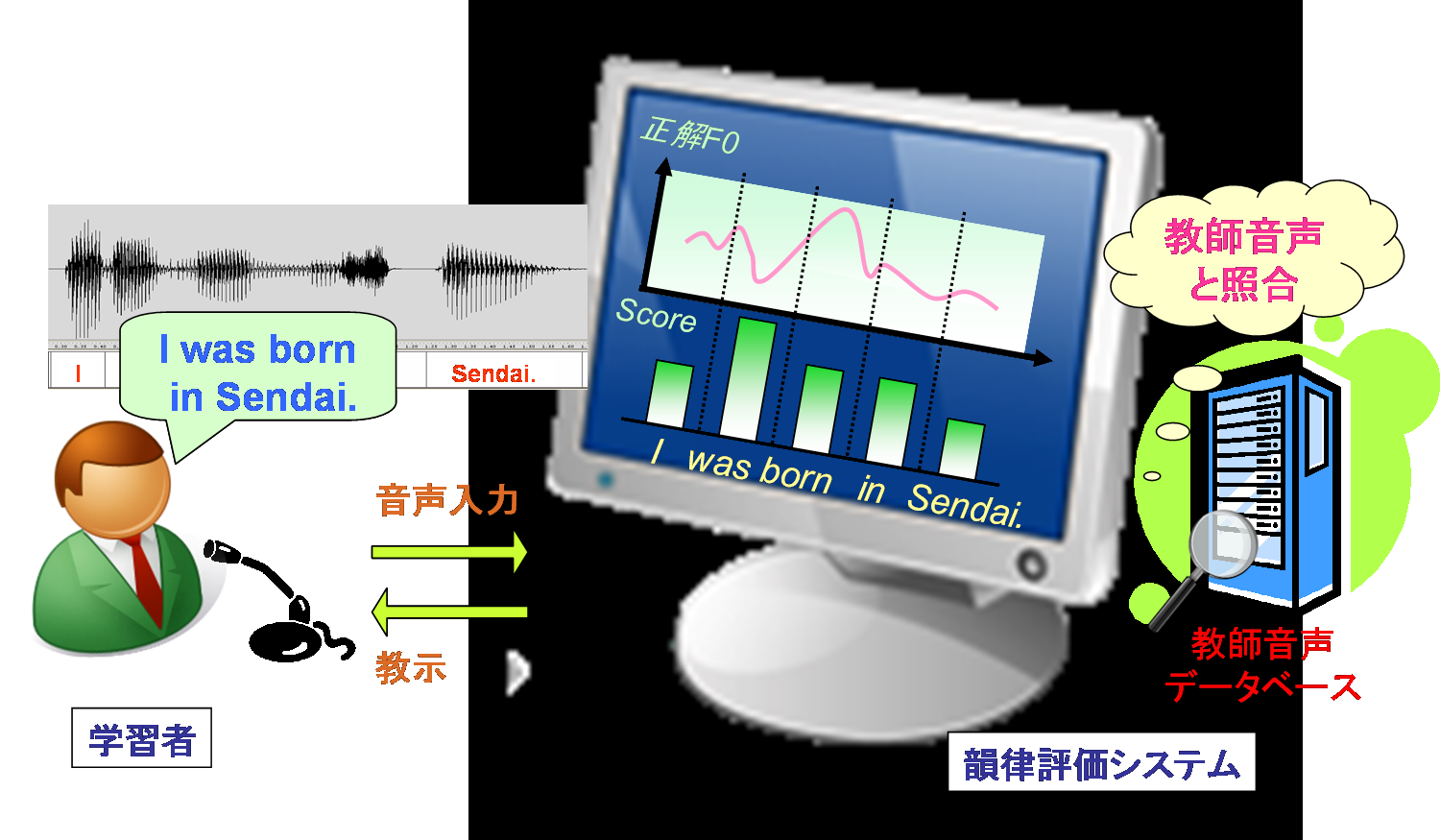

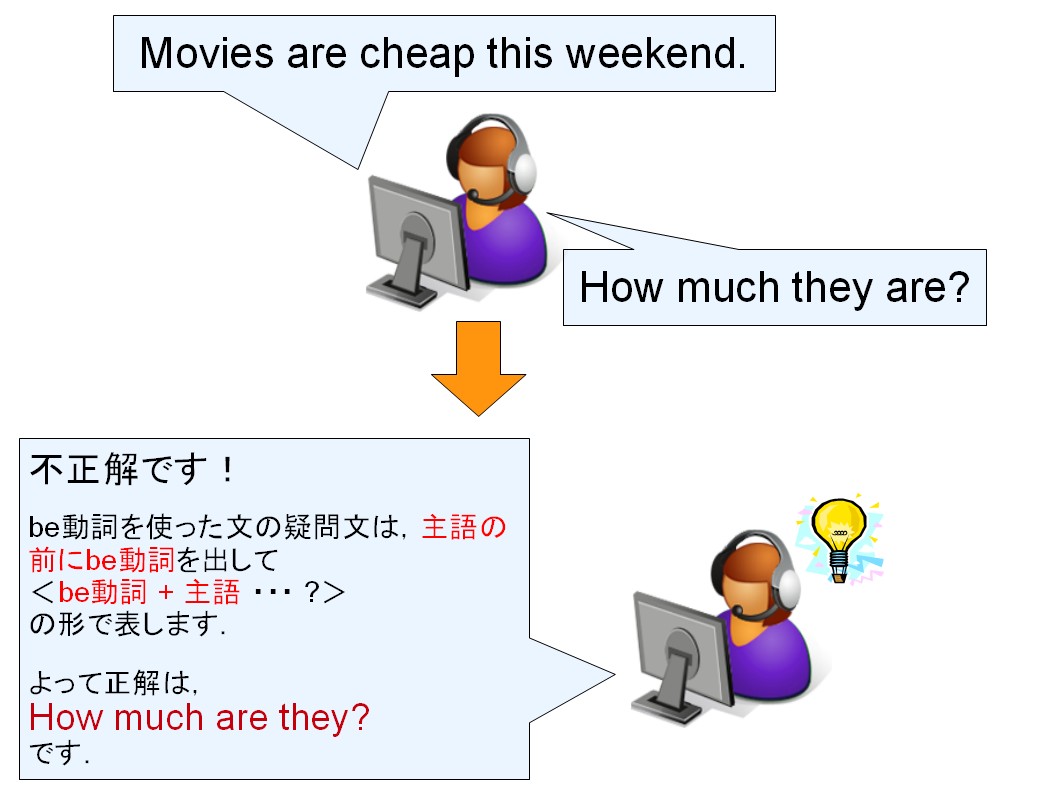

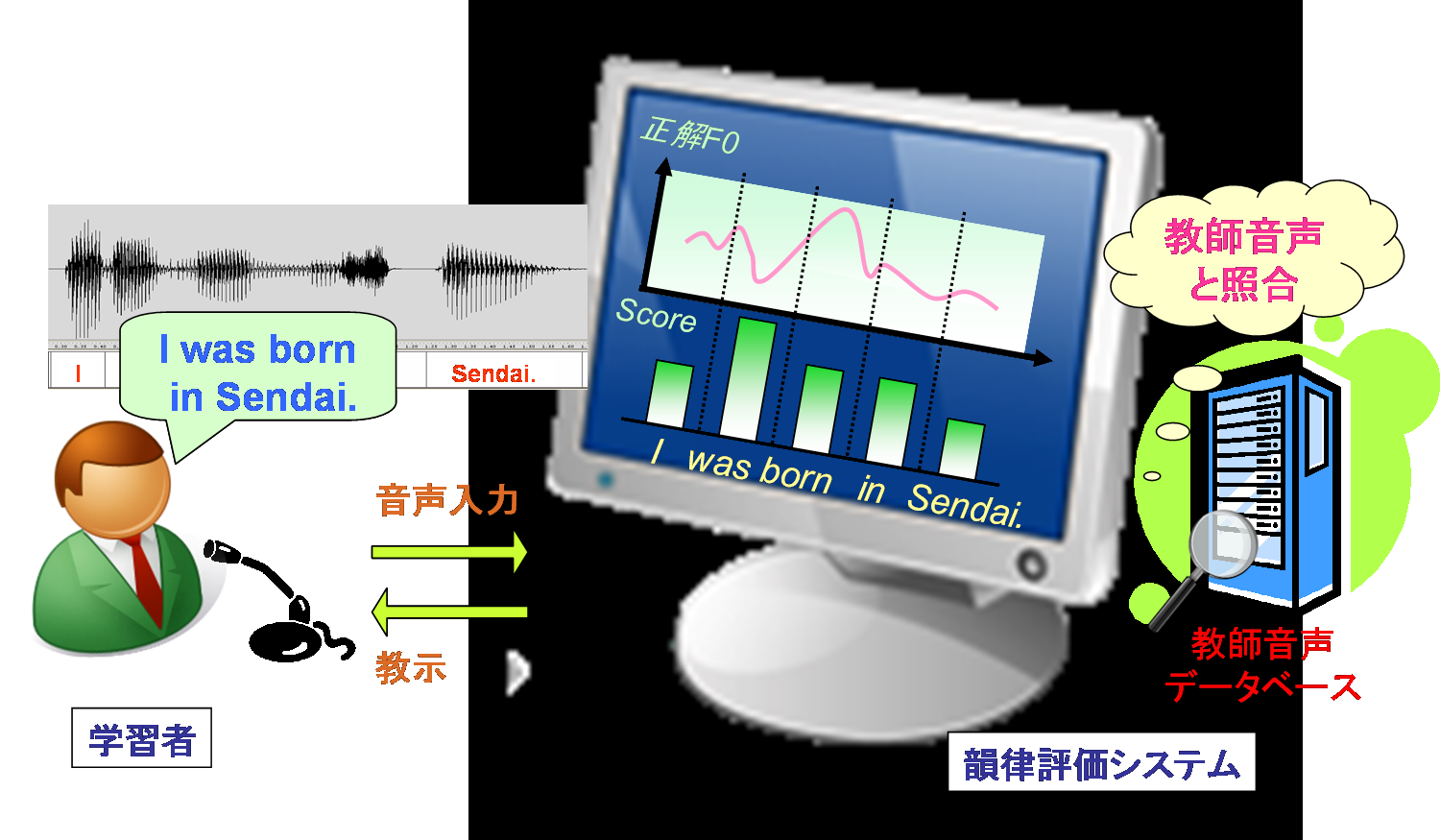

音声言語処理を応用した外国語教育システム

■外国語学習支援システム

近年の国際化とともに、英語を習得したいと考える人が増えてきています。

さらに学校教育において、2011年度から小学校5、6年で英語の必修授業が始まるなど、

国としても早い段階からの英語学習を必要不可欠なものとしていることが伺えます。

従来の英語学習では「読む」、「書く」能力に重点が置かれていましたが、

海外旅行やビジネスのような場面での英語を用いたコミュニケーションの機会は確実に増えてきており、

それに伴って「聞く」、「話す」といった会話能力の重要性も高まってきています。

これらの能力のうち、「聞く」能力に関しては、テレビやラジオの教育番組、CDやDVD教材の普及、

インターネットなどによって、比較的簡単に訓練することができると言えます。

しかし、「話す」能力については、例えば音読やシャドーイングといった方法にはフィードバックがなく、

また、語学留学や英会話学校に通うといった方法も、時間や費用がかかるという問題があることから、気軽にできるとは言えません。このような背景により、コンピュータを利用して外国語を学習するCALL (Computer Assisted Language Learning)

システムに期待が高まってきており、様々な研究がされています。

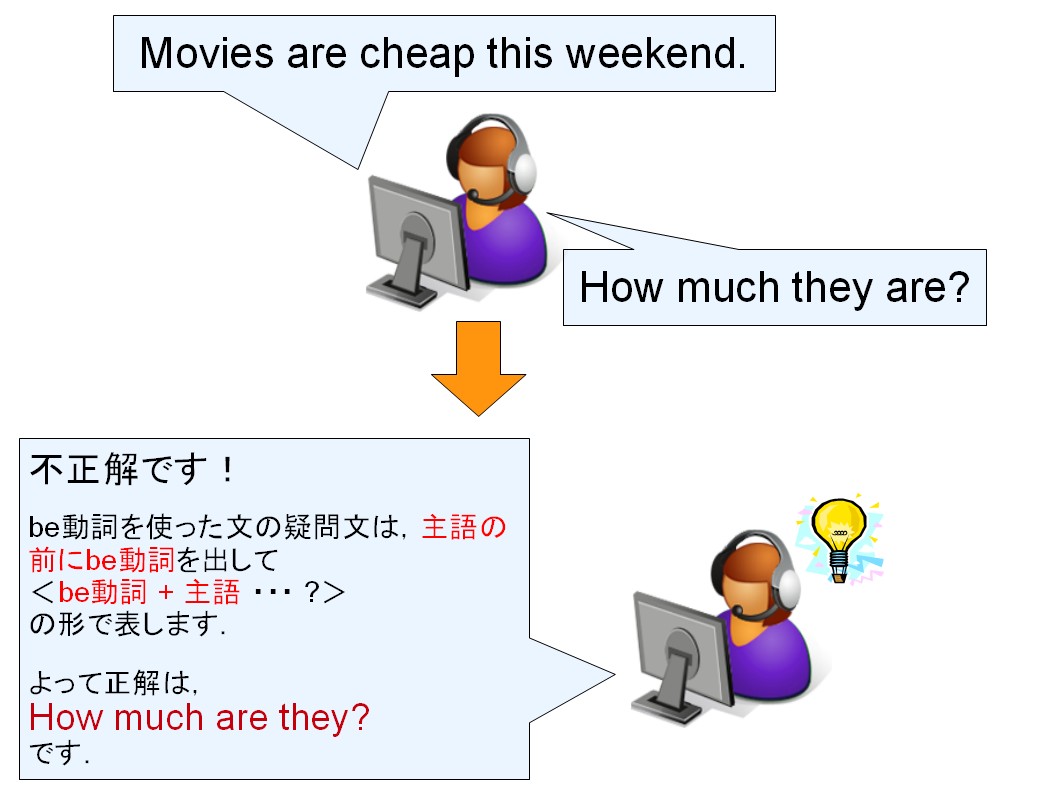

本研究室では、CALLシステムに音声認識の技術を用いることによって、コンピュータとの対話形式で実践的な

「話す」訓練ができるようなシステムの研究を行っています。

学習者が発話した英文の中から文法的な誤りや発音の誤りを自動的に検出することによって、

効率的な英語の学習ができるようにすることを目指します。

高度な音楽情報処理

■歌唱の「熱唱度」評価

カラオケで一生懸命に歌ったのに、採点結果がイマイチだったことはありませんか?

歌の素晴らしさは、決して音程の正確さだけで決まるわけではありません。

この研究では、歌の「うまさ」ではなく「熱唱度」、すなわちいかに一生懸命な歌唱であるかを測る手法を探っています。

歌声の大きさを測れば、熱唱の度合いを測れるでしょうか。答えはNoです。

いくつかの実験結果から、人が歌声を聞いたときに熱唱度を知覚する要因は、

声の大きさだけではないということがわかっています。

また声の大きさを正確に測ることは、実はとても難しいのです。

カラオケでマイクを口のすぐ近くに持ってきて歌うと、スピーカーから大きな音が出ます。

マイクを口から少し離して歌うと、音は小さくなるでしょう。

つまりマイクで測る音の大きさは、熱唱度とは関係なく、

歌う人の口とマイクとの距離によって変わってしまうのです。

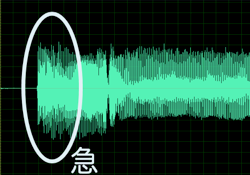

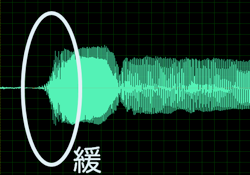

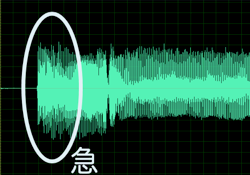

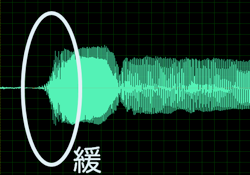

歌声をコンピューターに入力すると、図2.1,2,2のような音の波の形、すなわち波形を観察することができます。

図2.1と図2.2はそれぞれ、ある人が同じ曲を熱唱したときと普通に歌ったときの、波形の一部分です。

図2.1では音が急激に立ち上がっているのに対して、図2.2では緩やかに立ち上がっていることがわかります。

このような歌声を人が聞き比べた場合、音が急激に立ち上がる歌声のほうが、熱唱度を高く感じることがわかっています。

|

|

| 図2.1:熱唱度を高く感じる歌声 |

図2.2:熱唱度を低く感じる歌声 |

このように、歌声の波形をコンピューターによって分析することと、人が聞いたときに感じる熱唱度との関係を調べることで、

コンピューターによって自動的に熱唱度を評価する手法を研究しています。

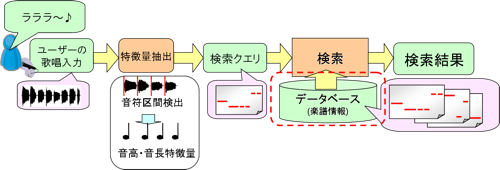

■ハミング楽曲検索

あの曲をカラオケで歌いたけど、曲名が思い出せない!

あの曲のCDを買いたいけど、歌手名が思い出せない!そんな経験が誰にでもあるでしょう。

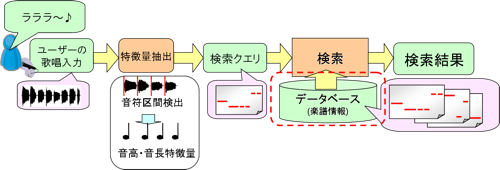

マイクに向かってメロディを歌うことで、楽曲を検索する手法の研究をしています。

マイクに向かって「ラララ・・」などと歌って音程を入力することを、「ハミング入力」と呼んでいます。

ハミング入力から音程を抽出する技術はある程度確立されていますが、そこから楽曲を検索することは、簡単ではありません。

メロディをよく覚えていなくて、音程を間違えて歌ったり、音が抜けてしまうことがよくあるからです。

また人間の歌声の音程はとても不安定で、正しい音程からずれていたり、ゆらいだりするのが普通です。

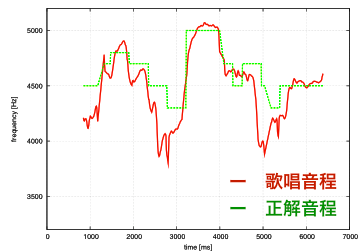

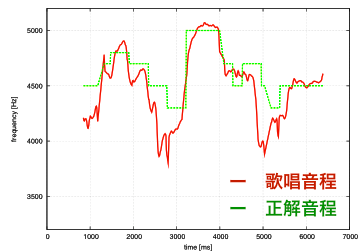

図2は、ある曲を人間が歌った際の音程(赤線)と、その曲の正しい音程(緑線)を示したものです。

人間が歌った音程は、正しい音程からずいぶんと外れていることがわかります。

このように不安定な入力に対しても、正しく楽曲検索をするための手法が、研究の大きな課題です。

ハミング入力から楽曲を検索するためには、楽曲の音程情報を蓄積したデータベースが必要です。

世の中に存在する膨大な楽曲から、人手で音程の情報を抽出する作業(採譜)は、時間や費用の観点から現実的ではないでしょう。

そこで、CDなどに収録された楽曲から、自動的に音程のデータベースをつくる技術が必要になります。

CDにはボーカルだけでなく、種々の楽器による伴奏や効果音など、実に様々な音が収録されています。

このような混合音からボーカルの音程(または主旋律となる音程)だけを抽出することは非常に難しく、正確に抽出できる手法は未だ確立されていません。

そのため、複数の音程を「正解候補」として抽出しておき、検索するなどのアプローチを試みています。

音程抽出の誤りをある程度許容して、ハミング入力からの検索に適した楽曲データベースつくる手法が、本研究の課題のひとつです。

高度な音楽配信技術

■パケットロスを隠蔽する音楽配信

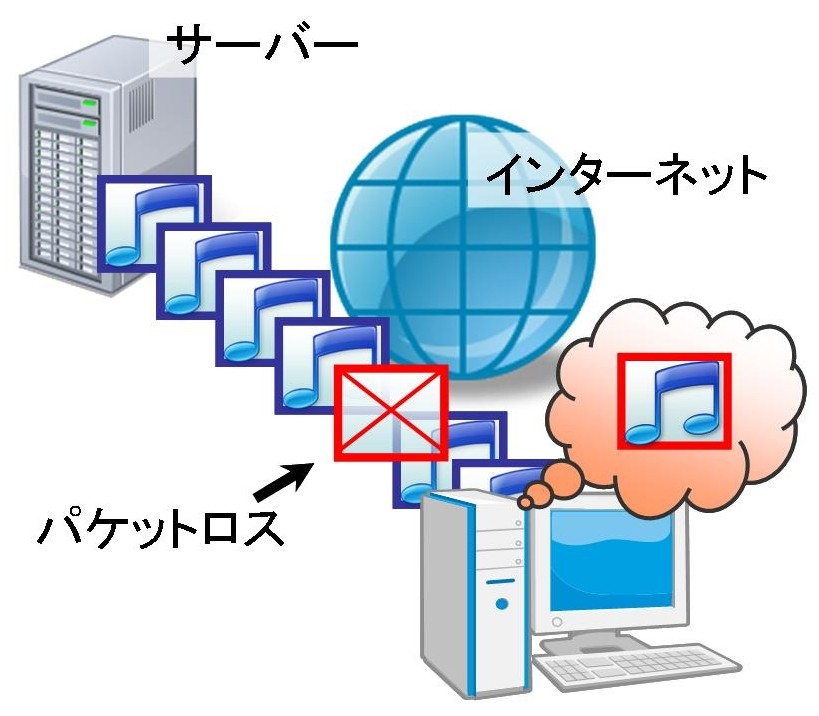

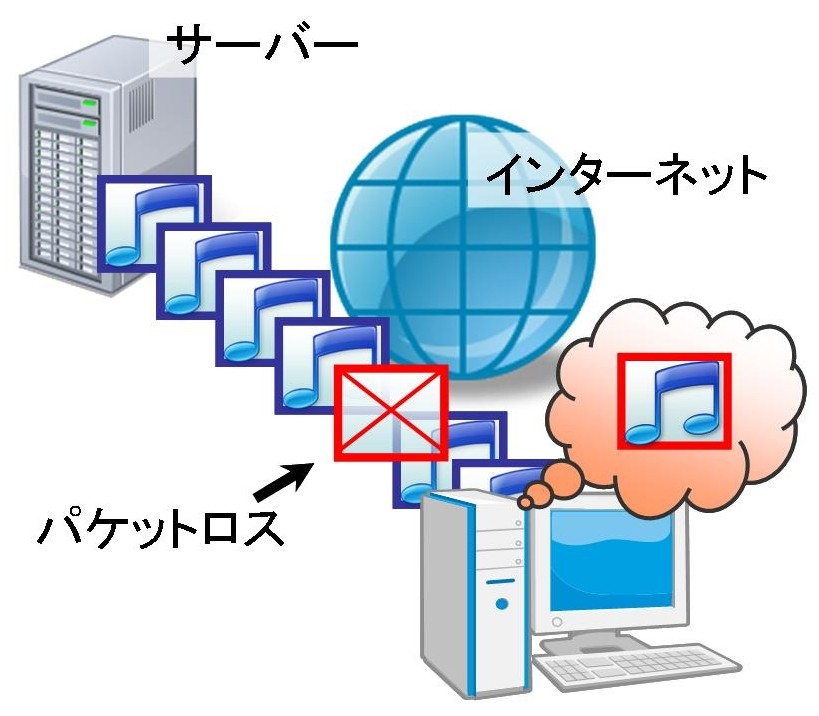

近年、インターネット上での音楽のストリーミング配信が盛んになってきてます。

ストリーミング配信時に起こる通信中の誤りやデータの遅延は、

データの欠落(パケットロス)を生じさせ、音質劣化の原因となります。

現在多くのサービスではTCPと呼ばれる通信方法が用いられてますが、

この方法は通信効率が悪いということが知られています。

そこで我々は、パケットロスに対して過去のフレームから得られる

相関を基にデータを推定することで欠落を隠蔽する方法について検討し、

ストリーミング配信における音質の改善、通信効率の改善を実現できるように研究を行っています。

■楽曲のストリーミング配信のための混合音操作技術

■楽曲のストリーミング配信のための混合音操作技術

インターネット上で音楽を配信し、その音楽を聴くことは一般的になってきています。

もしも配信されている楽曲に対し、パートごとの音量調節が可能になれば、

自分の好きな楽曲に対してカラオケ化やリミックスを行うといった様々な楽しみ方の可能性が広がります。

しかし従来の混合音操作の研究手法は、ストリーミング配信されている楽曲信号に対しリアルタイムで操作を行うには不向きでした。

そこで我々は、ミックス前の音声信号の特徴を付加情報として

楽曲信号に加えて送信する方法を検討し、

少ない情報量で精度良くリアルタイムでの操作を可能にするための方法について研究を行っています。